Frauen können heutzutage alle Hindernisse überwinden und sich wie die Männer auf prestigereiche Jobs bewerben. Könnten sie, ja. Wenn ihnen diese Jobs überhaupt mal angezeigt werden würden.

Algorithmen sind sexistisch

Wie genau das gemeint ist, hat vor kurzem die NGO AlgorithmWatch gezeigt und dabei erforscht, wem der Algorithmus von Facebook eigentlich welche Stellenanzeigen ausspielt. Die Organisation testete das anhand fiktiver Jobausschreibungen etwa für Lkw-Fahrer:innen, Erzieher:innen, Pfleger:innen. Dreimal dürft ihr raten, was bei diesem Experiment herauskam: Der Lkw-Job wurde an sage und schreibe 4864 Facebook-Nutzer ausgespielt, aber nur an 386 Nutzerinnen. Damit bekamen die Lkw-Anzeige zu 93 Prozent allein Männer zu sehen. Den Erzieher:innen-Job hingegen bekamen – oh, Überraschung – nur 258 Männer zu sehen, dafür aber in 6456 Fällen und damit zu 96 Prozent Frauen. Ist doch total logisch, dachte sich der Algorithmus wahrscheinlich, Frauen können doch eh nicht Auto fahren, dafür aber besonders gut Windeln wechseln. Digitale Klischeehölle wie sie im Buche steht.

Google hatte ebenfalls mal einen Shitstorm an der Backe, als eine Untersuchung der US-amerikanischen Carnegie Mellon University gezeigt hat, dass die Suchmaschine Frauen weniger gut bezahlte Führungsstellen anzeigt als Männern. Und bei Apple hatten Algorithmen, die über Kreditvergaben entschieden, Frauen niedrigere Kredite angeboten als Männern. Selbst Apple-Mitbegründer Steve Wozniak hatte bestätigt, dass die offizielle Kreditkarte von Apple, die Apple Card, seiner Frau einen zehnmal geringeren Kreditrahmen gewährt hatte als ihm selbst – obwohl ihre Vermögenswerte exakt dieselben waren. Sicherlich wurde der Algorithmus nicht darauf programmiert, Frauen absichtlich schlechter zu bewerten, das Programm hatte einfach die Muster der Vergangenheit gelesen – dass Frauen meist finanziell schlechter aufgestellt sind – und hat diese Vergangenheit einfach auf andere Frauen projiziert. Eine patriarchale Endlosschleife.

Und noch ein Algorithmus-Totalausfall: Falls du immer mal das Gefühl hast, du wirst bei Zoom, Teams etc. irgendwie weniger gehört oder gleich ganz überhört oder ignoriert – könnte es daran liegen, dass künstliche Intelligenzen für Videocall-Software zu selten mit weiblichen Stimmen gefüttert wurden, folglich weibliche Stimmen seltener erkennen und die Programme Frauenstimmen in unser aller täglichen Videocalls schlechter übertragen. Ohne Witz! Hat erst 2021 eine Untersuchung von Wissenschaftler:innen der Universität Magdeburg und der dänischen Universität Sønderborg ergeben. Was psychologisch für uns zur Folge hat, dass diese schlecht übertragenen Frauenstimmen uns unterbewusst weniger charismatisch, weniger ausdrucksstark und – jetzt kommt’s – weniger kompetent vorkommen. Was soll man dazu noch sagen …

Nachschlag gefällig?

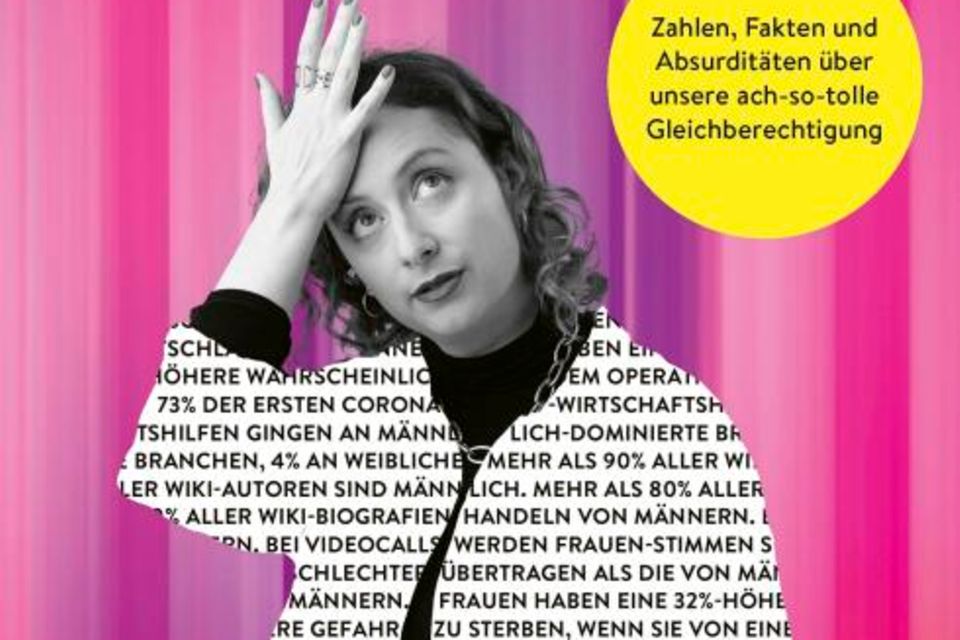

Frauen sterben eher, wenn sie von einem Mann statt von einer Frau operiert werden; die Inflation ließ Preise für weibliche Kleidung höher steigen als für männliche … Weitere Fakten zum Haareraufen liefert Alexandra Zykunov in "Was wollt ihr denn noch alles?!". (304 S., 16 Euro, Ullstein)